来源:小编 更新:2024-11-17 01:52:25

用手机看

在机器学习和数据科学领域,Ensemble(集成)是一种强大的技术,它通过结合多个模型的预测结果来提高整体性能。本文将深入探讨Ensemble技巧,帮助您了解如何有效地提升模型的预测能力。

Ensemble是一种将多个模型的结果进行融合的技术,旨在提高预测的准确性和稳定性。它通过结合多个模型的预测结果,可以减少单个模型的过拟合风险,并提高模型的泛化能力。

Ensemble方法主要有以下几种:

Bagging(Bootstrap Aggregating)

Boosting

Stacking

Blending

Bagging是一种通过从原始数据集中随机抽取子集来训练多个模型的方法。每个模型都是独立的,并且使用不同的数据子集进行训练。Bagging的主要目的是减少模型的方差,提高模型的稳定性。

具体步骤如下:

从原始数据集中随机抽取n个样本,形成一个新的数据子集。

使用这个数据子集训练一个模型。

重复步骤1和2,共进行k次,得到k个模型。

将k个模型的预测结果进行融合,得到最终的预测结果。

Boosting是一种迭代地训练模型的方法,每次迭代都根据前一次迭代中预测错误的样本来调整样本权重。Boosting的主要目的是减少模型的偏差,提高模型的准确性。

具体步骤如下:

初始化样本权重,使得所有样本的权重相等。

使用当前样本权重训练一个模型。

根据模型的预测错误率,调整样本权重,使得预测错误的样本权重增加。

重复步骤2和3,共进行k次,得到k个模型。

将k个模型的预测结果进行融合,得到最终的预测结果。

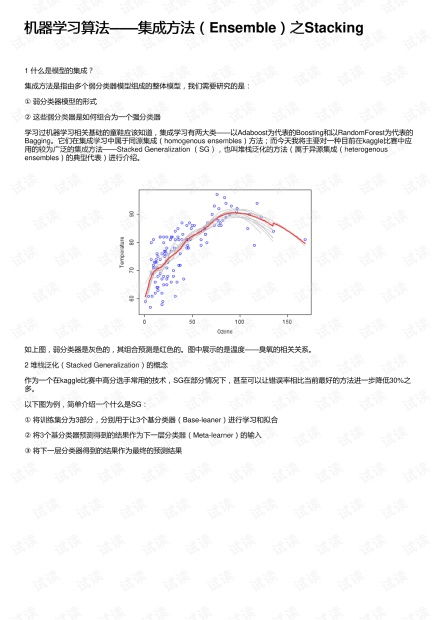

Stacking是一种将多个模型的结果作为输入,训练一个更复杂的模型的方法。Stacking通常分为两个层次:底层是多个基础模型,顶层是一个复杂的模型。

具体步骤如下:

使用交叉验证将数据集拆分为多个训练集和验证集。

使用每个训练集训练一个基础模型,并将预测结果保存为特征。

使用所有基础模型的预测结果作为输入,训练一个顶层模型。

使用顶层模型的预测结果作为最终预测结果。

Blending是一种将多个模型的预测结果进行加权平均的方法。与Stacking不同,Blending不需要训练一个顶层模型,而是直接对多个模型的预测结果进行加权平均。

具体步骤如下:

使用交叉验证将数据集拆分为多个训练集和验证集。

使用每个训练集训练一个模型,并将预测结果保存为特征。

使用所有模型的预测结果作为输入,进行加权平均,得到最终的预测结果。

Ensemble技巧是一种强大的模型融合方法,可以帮助我们提高模型的预测能力。在实际应用中,我们可以根据具体问题选择合适的Ensemble方法,并结合交叉验证等技术来优化模型性能。

选择合适的模型组合:不同的模型具有不同的优势和劣势,合理选择模型组合可以提高整体性能。

调整模型参数:优化模型参数可以提高模型的预测准确性。

使用交叉验证:交叉验证可以帮助我们评估模型的泛化能力,并选择最佳的